Схема автогенератора

Рис. 3 Схема автогенератора

Рис. 4 Струнный автогенератор АГ-4 с автономным питанием

Вывод струны электрически изолирован от корпуса датчика и присоединяется ко входу автогенератора (АГ-4) (представлен на рис.4)

Второй вывод струны соединен с корпусом датчика и с помощью кабеля соединен со входом 4 автогенератора.

(Всё сказанное ранее относителось к классическому УИП 8: с автогенератором, частотомером.

МПСИ позволяет убрать автогенератор и снимать измерения с помощью затухающих колебаний.)

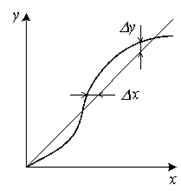

Автогенератор преобразует изменение частоты колебаний механической системы в изменение частоты электрического выходного напряжения.

В струнном автогенераторе используется операционный усилитель. Роль частотозадающего элемента выполняет струна, которая является высокодобротной механической колебательной системой с линейно-распределенными параметрами.

Резисторы R1 и R2 устанавливают режим работы операционной усителя (ОУ) по постоноянному току.

Отрицательная обратная часть черз R1 и R2 и конденсатор С1 задают коэффициенты усиления ОУ.

Резистор R5, подключённый к точкам 1 и 2 и размещенный в корпусе УИП-8, регулирует глубину положительной обратной связи,определяющей амплитуду колебаний струны и форму сигнала на выходе.

Конденсатор С2 применяется с целью развязки выхода автогенератора и перегрузки по постоянному току.

Вход 2 автогенератора подключен к струне, а вход 4 – к УИП-8

Алгоритмы контроля и обеспечения качества измерений. Составляющие погрешности измерений

Погрешнось средств измерений и результатов измерений.

Погрешность измерений следует разделить на:

Погрешность средств измерений

Погрешность результатов измерений

Погрешность средств измерений – отклонение метрологических свойств или параметров средств измерений от номинальных, влияющих на погрешность результатов измерений, создающие так называемые инструментальные ошибки измерений.

Погрешность результата измерения - отклонение результатата измерений х изм от действительного, те истинного значения измеряемой величины х 0 и определяется по формуле:

Δх=х изм – х 0

Погрешности средств измерений можно разделить на:

Инструментальную

Методическую

Методическая погрешность обусловлена несовершенством метода измерений или упрощениями допущенными при измерении, (например, она возникает из-за использования приближенных формул подсчеста результата или неправильной методики проведения измерения).

Выбор ошибочныой методики возможен из-за несоответствия (т.е. неадекватности) измеряемой физической величины и ее модели.

Причины методической погрешности м.б. как неучитываемое взаимное влияние объекта измерений и измерительных приборов или недостаточная точность такого учета.

(Как пример – методическая погрешность возникает при измерениях падения напряжения на участках цепи с помощью вольтметра, т.к. из-за действия вольтметра измеряемое напряжение уменьшается).

Механизм взаимного влияния м.б. изучен, а погрешности рассчитаны и учтены.

Инструментальная погрешность обусловлена несовершенством применяемых средств измерений.

Причинами ее возникновения являются неточности, допущенные при изготовлении и настройки приборов, изменение параметров элементов контрукции и схемы вследствие старения.

В высокочувствительных приборах могут сильно проявлятся их совственные внутренние шумы.

Статическая и динамическая погрешности.

Статическая погрешность – погрешность результатат измерений, свойственная условиям статического измерения (т.е. при измерении постоянных величин после завершения переходных процессов в элементах приборов и преобразователей).

Динамическая погрешность измерений – погрешность результатов измерений, свойственная результатам динамического измерения.

Динамическая погрешность появляется при измерении переменных величин и обусловлена инерционными свойствами средств измерений.

Статическая и динамическая погрешности относятся к погрешностям результата измерений.

В большинстве приборов статическая и динамическая погрешности оказываются связаны между собой, т.к. соотношение между этими видами погрешностей зависит от характеристик прибора и характерного времени измерения величины.

Систематические случайные погрешности

Систематическая погрешность измерений – составляющая погрешности измерений, остающаяся постоянной или закономерно изменяющаяся при повторных измерениях одной и той же физической величины.

Систематические погрешности являются функцией измеряемой величины, влияющих величин и времени. Величнами могут быть: температура, влажность, напряжение.

Все систематические погрешности входят при поверке и аттестации образцовых приборов.

Случайными называют составляющие погрешности измерений, изменяющиеся случайным образом при повторных измерениях одной и той же величины.

Случайные погрешности определяются совместным действием ряда причин:

Внутренние шумы элементов электронных схем

Наводки на входные цепи средств измерений

Пульсация постоянного питающего напряжения

Дискретность счета

Погрешности адекватности и градуировки

Погрешность градуировки средств измерений – погрешность действиетльного значения величны, приписаного той или иной отметке шкалы средства измерения в результате градуировки.

Погрешностью адекватности модели – погрешность при выборе функциональной зависимости.

Характерным примером может служить построение линейной зависимости по данным, которые лучше описываются степенным рядом с малыми нелинейными членами.

Погрешность адекватности относится к измерениям для проверки модели.

Если зависимость параметра состояния от уровня входного фактора задана при моделировании объекта достаточно точно, то погрешность адекватности оказывается минимальна.

Она может зависит от динамического диапазона измерений. (Например, если однофакторная зависимость у=f(х) задана при моделировании параболой, то в небольшом диапазоне она будет мало отличаться от экспоненциальной зависимости.

Если же диапазон измерений увеличить, то погрешность адекватности сильно возрастет.)

Под абсолютной погрешностью понимается алгебраическая разность между номинальным и действительным значением измеряемой величины.

Δх=х н - х д

где, Δх и Δу – абсолютные погрешности.

В большей степени точность средств измерений характеризует относительная погрешность . Т.е. выраженное в процентах отношение абсолютной погрешности к действительному значению измеряемой или воспроизводимой данным средством измерения величины

ε=Δх/х д *100%

где отношение Δх/х и Δу/у –относительные погрешности

Если же диапазон измерения прибора охватывает и нулевое знчение измеряемой величины, то относительная погрешность обращается в бесконечность соответствуюую ему точки шкалы.

В таком случае пользуются понятием приведенной погрешности , которая равна отношению абсолютной прибора к некоторому нормирующему значению.

γ=Δх/х норм

В качествестве нормирующего значения принимается значение, характерное для данного вида измерительного прибора (это м.б. диапазон измерий, верхний предел измерений, длина шкалы)

Δх/Х, Δу/У –есть приведенные погрешности, где Х и У – диапазоны измерения величин.

Выбор Х и У в каждом случае разный из-за нижнего предела чувствительности прибора.

Адитивные и мультиплекативные погрешности

Адитивной называется погрешность, постоянная в каждой точке шкалы.

Мультиплекативной называется погрешность, линейно-возрастающая или убываюшая с ростом измеряемой величины.

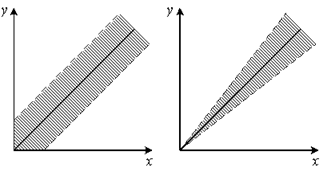

Различать адитивные и мультиплекативные погрешности легче всего по полосе погрешностей.

Если же абсолютная погрешность не зависит от измеряемой величины, то полоса определяется адитивной погрешностью (ее ещё называют погрешностью нуля) 2.2.а

Если постоянной величиной является относительная погрешность, то полоса погрешности меняется в пределах диапазона измерений – погрешность называется мультиплекативной. 2.2.б

Абсолютная погрешность - алгебраическая разность между номинальным и действительным значениями измеряемой величины. Абсолютная погрешность измеряется в тех же единицах измерения, что и сама величина, в расчетах её принято обозначать греческой буквой - ∆.

Относительная погрешность - отношение абсолютной погрешности к тому значению, которое принимается за истинное. Относительная погрешность является безразмерной величиной, либо измеряется в процентах, в расчетах обозначается буквой - δ.

Приведённая погрешность - погрешность, выраженная отношением абсолютной погрешности средства измерений к условно принятому значению величины, постоянному во всем диапазоне измерений или в части диапазона.

Аддитивные и мультипликативные погрешности .

Аддитивной погрешностью называется погрешность, постоянная в каждой точке шкалы.

Мультипликативной погрешностью называется погрешность, линейно возрастающая или убывающая с ростом измеряемой величины.

Грубая погрешность – случайная погрешность результата отдельного измерения и входящего в ряд измерений и резко отличающихся от остальных измерений.

Промахи, как правило, возникают из-за ошибок или неправильных действий оператора

16. Обработка результатов прямых многократных измерений

При измерениях любую искомую физическую величину определяют всегда с некоторой погрешностью. В задачу измерений входит не только получение наиболее вероятного значения искомой величины, но и оценка допущенной при измерениях погрешности. Принято различать прямые и косвенные измерения. При прямых измерениях искомое значение величины находят непосредствен но путем наблюдений (например, измерение длины линейкой, силы тока – амперметром, массы – пружинными весами). При косвенных измерениях искомое значение величины находят на основании известной зависимости между этой величиной и величинами, определенными в прямых измерениях (например: определение площади прямоугольника по длине его сторон, силы тока – по напряжению и сопротивлению электрической цепи и т. п.). Независимо от вида измерения экспериментатор должен записывать результат с указанием наиболее вероятного значения (оценки) искомой величины и интервала, в котором оно содержится, а также доверительной вероятности, т. е. надёжности результата измерений. Обычно измерения проводят многократно, путем нескольких наблюдений.

17. основы обеспечения единства измерений

Единство измерений - состояние измерений, при котором их результаты выражены в допущенных к применению в Российской Федерации единицах величин, а показатели точности измерений не выходят за установленные границы. Данное определение дано в федеральном законе. Определение понятия «единство измерений» довольно емкое. Оно охватывает важнейшие задачи метрологии: унификацию единиц, разработку систем воспроизведения единиц и передачи их размеров рабочим средствам измерений с установленной точностью, проведение измерений с погрешностью, не превышающей установленные пределы и др. Единство измерений должно выдерживаться при любой точности измерений, необходимой владельцу процесса. Для обеспечения единства измерений следует выражать результаты измерений в стандартных единицах. Кроме того, должна быть точно известна погрешность выполненных измерений. Для достижения требуемой точности погрешность измерений не должна превосходить предельно допустимых значений.

18. Государственная система обеспечения единства измерений

Правовые основы обеспечения единства измерений установлены Законом РФ "Об обеспечении единства измерений". Закон регулирует отношения государственных органов управления Российской Федерации с юридическими и физическими лицами по вопросам изготовления, выпуска, эксплуатации, ремонта, продажи и импорта средств измерений и направлен на защиту прав и законных интересов граждан, установленного правопорядка и экономики Российской Федерации от отрицательных последствий недостоверных результатов измерений. Если международным договором Российской Федерации установлены иные правила, чем те, которые содержатся в законодательстве Российской Федерации об обеспечении единства измерений, то применяются правила международного договора.

Погрешность средства измерений (англ. error (of indication) of a measuring instrument) – разность между показанием средства измерений и истинным (действительным) значением измеряемой физической величины.

Систематическая погрешность средства измерений

(англ. bias error of a measuring instrument) – составляющая погрешности средства измерений, принимаемая за постоянную или закономерную изменяющуюся.

Примечание. Систематическая погрешность данного средства измерений, как правило, будет отличаться от систематической погрешности другого экземпляра средства измерений этого же типа, вследствие чего для группы однотипных средств измерений систематическая погрешность может иногда рассматриваться как случайная погрешность.

Случайная погрешность средства измерений (англ. repeatability error of a measuring instrument) – составляющая погрешности средства измерений, изменяющаяся случайным образом.

Абсолютная погрешность средства измерений – погрешность средства измерений, выраженная в единицах измеряемой физической величины.

Относительная погрешность средства измерений – погрешность средства измерений, выраженная отношением абсолютной погрешности средства измерений к результату измерений или к действительному значению измеренной физической величины.

Приведенная погрешность средства измерений

(англ. reducial error of a measuring instrument) – относительная погрешность, выраженная отношением абсолютной погрешности средства измерений к условно принятому значению величины, постоянному во всем диапазоне измерений или в части диапазона.

Примечания:

- Условно принятое значение величины называют нормирующим значением. Часто за нормирующее значение принимают верхний предел измерений.

- Приведенную погрешность обычно выражают в процентах.

Основная погрешность средства измерений (англ. intrinsic error of a measuring instrument) – погрешность средства измерений, применяемого в нормальных условиях.

Дополнительная погрешность средства измерений (англ. complementary error of a measuring instrument) – составляющая погрешности средства измерений, возникающая дополнительно к основной погрешности вследствие отклонения какой-либо из влияющих величин от нормального ее значения или вследствие ее выхода за пределы нормальной области значений.

Статическая погрешность средства измерений – погрешность средства измерений, применяемого при измерении физической величины, принимаемой за неизменную.

Динамическая погрешность средства измерений – погрешность средства измерений, возникающая при измерении изменяющейся (в процессе измерений) физической величины.

Погрешность меры – разность между номинальным значением меры и действительным значением воспроизводимой ею величины.

Стабильность средства измерений

(англ. stability) – качественная характеристика средства измерений, отражающая неизменность во времени его метрологических характеристик.

Примечание. В качестве количественной оценки стабильности служит нестабильность средства измерений.

Нестабильность средства измерений

– изменение метрологических характеристик средства измерений за установленный интервал времени.

Примечания:

- Для ряда средств измерений, особенно некоторых мер, нестабильность является одной из важнейших точностных характеристик. Для нормальных элементов обычно нестабильность устанавливается за год.

- Нестабильность определяют на основании длительных исследований средства измерений, при этом полезны периодические сличения с более стабильными средствами измерений.

Точность средства измерений

(англ. accuracy of a measuring instrument) – характеристика качества средства измерений, отражающая близость его погрешности к нулю.

Примечание. Считается, что чем меньше погрешность, тем точнее средство измерений.

Класс точности средств измерений

(англ. accuracy class) – обобщенная характеристика данного типа средств измерений, как правило, отражающая уровень их точности, выражаемая пределами допускаемых основной и дополнительных погрешностей, а также другими характеристиками, влияющими на точность.

Примечания:

- Класс точности дает возможность судить о том, в каких пределах находится погрешность средства измерений одного типа, но не является непосредственным показателем точности измерений, выполняемых с помощью каждого из этих средств. Это важно при выборе средств измерений в зависимости от заданной точности измерений.

- Класс точности средств измерений конкретного типа устанавливают в стандартах технических требований (условий) или в других нормативных документах.

Предел допускаемой погрешности средства измерений

– наибольшее значение погрешности средств измерений, устанавливаемое нормативным документом для данного типа средств измерений, при котором оно еще признается годным к применению.

Примечания:

- При превышении установленного предела погрешности средство измерений признается негодным для применения (в данном классе точности).

- Обычно устанавливают пределы допускаемой погрешности, то есть границы зоны, за которую не должна выходить погрешность.

Пример. Для 100-миллиметровой концевой меры длины 1-го класса точности пределы допускаемой погрешности +/- 50 мкм.

Нормируемые метрологические характеристики типа средства измерений – совокупность метрологических характеристик данного типа средств измерений, устанавливаемая нормативными документами на средства измерений.

Точностные характеристики средства измерений

– совокупность метрологических характеристик средства измерений, влияющих на погрешность измерения.

Примечание. К точностным характеристикам относят погрешность средства измерений, нестабильность, порог чувствительности, дрейф нуля и др.

Погрешность СИ - разность между показанием средства измерений - X п и истинным (действительным) значением измеряемой величины - Х д.

Абсолютная погрешность СИ - погрешность средства измерений, выраженная в единицах измеряемой величины: ∆Х = X п − Х д. Абсолютная погрешность удобна для практического применения, т.к. дает значение погрешности в единицах измеряемой величины. Но при ее использовании трудно сравнивать по точности приборы с разными диапазонами измерений. Эта проблема снимается при использовании относительных погрешностей.

Если абсолютная погрешность не изменяется во всем диапазоне измерения, то она называется аддитивной, если она изменяется пропорционально измеряемой величине (увеличивается с ее увеличением), то она называется мультипликативной.

Аддитивная составляющая не зависит от чувствительности прибора и остаётся постоянной для всех значений входной величины (Δ a =const) .

Мультипликативная составляющая зависит от чувствительности прибора и изменяется пропорционально текущему значению входной величины (Δ m =b x) .

Полная погрешность (3) равна сумме аддитивной и мультипликативной составляющих.

(Δ п = Δ a + Δ m) .

Относительная погрешность СИ - погрешность средства измерений, выраженная отношением абсолютной погрешности СИ к результату измерений или к действительному значению измеренной величины: δ = ∆Х / Х д. Относительная погрешность дает наилучшее из всех видов погрешностей представление об уровне точности измерений, который может быть достигнут при использовании данного средства измерений. Однако она обычно существенно изменяется вдоль шкалы прибора, например, увеличивается с уменьшением значения измеряемой величины. В связи с этим часто используют приведенную погрешность.

Приведенная погрешность СИ - относительная погрешность, выраженная отношением абсолютной погрешности средства измерений к условно принятому значению величины ХN, которое называют нормирующим : γ = ∆Х / Х N .

Относительные и приведенные погрешности обычно выражают либо в процентах , либо в относительных единицах (долях единицы) .

Для показывающих приборов нормирующее значение устанавливается в зависимости от особенностей и характера шкалы. Приведенные погрешности позволяют сравнивать по точности средства измерений, имеющие разные пределы измерений, если абсолютные погрешности каждого из них не зависят от значения измеряемой величины.

По условиям проведения измерений погрешности средств измерений подразделяются на основные и дополнительные .

Основная погрешность СИ - погрешность средства измерений, применяемого в нормальных условиях, т.е. в условиях, которые определены в НТД не него как нормальные. Нормальные значения влияющих величин указываются в стандартах или технических условиях на средства измерений данного вида в форме номиналов с нормированными отклонениями. Наиболее типичными нормальными условиями являются:

- температура (20 ± 5)єС;

- относительная влажность (65±15)%;

- атмосферное давление (100 ± 4) кПа или (750 ± 30) мм рт. ст.;

- напряжение питания электрической сети 220 В ± 2% с частотой 50 Гц.

Иногда вместо номинальных значений влияющих величин указывается нормальная область их значений. Например, влажность (30–80)%.

Дополнительная погрешность СИ - составляющая погрешности СИ, возникающая дополнительно к основной погрешности вследствие отклонения какой-либо из влияющих величин от нормального ее значения. Деление погрешностей на основные и дополнительные обусловлено тем, что свойства средств измерений зависят от внешних условий.

Погрешности по своему происхождению разделяются на систематические и случайные .

Систематическая погрешность СИ - составляющая погрешности средства измерений, принимаемая за постоянную или закономерно изменяющуюся. Систематические погрешности являются в общем случае функциями измеряемой величины и влияющих величин (температуры, влажности, давления, напряжения питания и т.п.).

Случайная погрешность СИ - составляющая погрешности средства измерений, изменяющаяся случайным образом. Случайные погрешности средств измерений обусловлены случайными изменениями параметров составляющих эти СИ элементов и случайными погрешностями отсчета показаний приборов.